งานวิจัยเผยการค้นหาข้อมูลด้วย AI กว่า 60 เปอร์เซ็นต์ให้ข้อมูลที่ไม่ถูกต้อง

มีปัญหาในทุกแพลตฟอร์มที่ใช้งาน

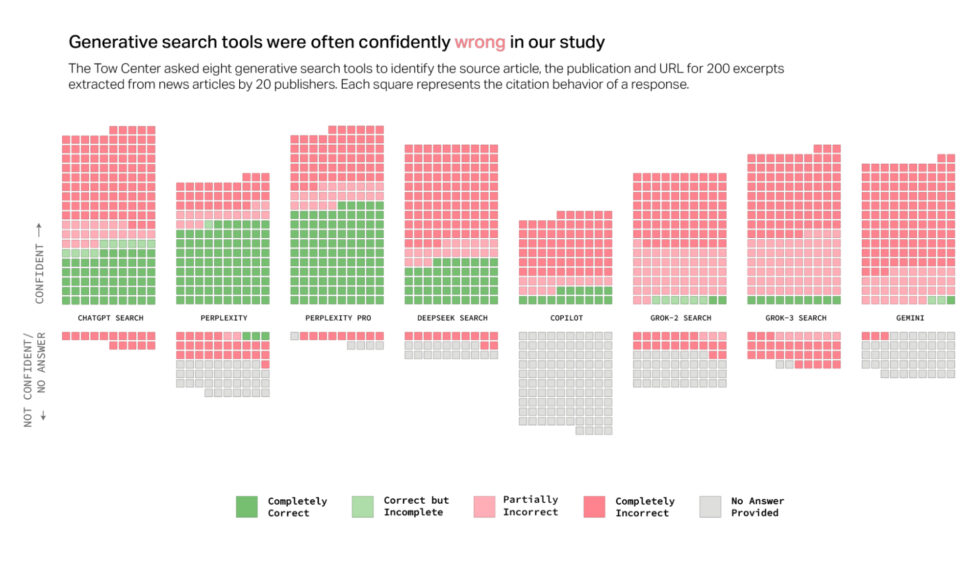

การศึกษาล่าสุดจาก Tow Center for Digital Journalism ของ Columbia Journalism Review พบปัญหาความแม่นยำในโมเดล AI ที่ใช้สำหรับการค้นหา โดยการวิจัยทดสอบเครื่องมือค้นหาด้วย AI จำนวน 8 รายการ ซึ่งมีฟังก์ชันการค้นหาแบบเรียลไทม์ และพบว่าโมเดล AI ตอบคำถามเกี่ยวกับเนื้อหาข่าวผิดพลาดมากกว่า 60% ของคำถามทั้งหมด

นักวิจัย Klaudia Jaźwińska และ Aisvarya Chandrasekar ระบุในรายงานว่าประมาณ 1 ใน 4 ของชาวอเมริกันใช้โมเดล AI แทนเครื่องมือค้นหาแบบเดิม ซึ่งสร้างความกังวลอย่างมากเกี่ยวกับความน่าเชื่อถือ เนื่องจากอัตราความผิดพลาดที่สูงในการศึกษานี้

อัตราความผิดพลาดแตกต่างกันอย่างเห็นได้ชัดในแต่ละแพลตฟอร์ม โดย Perplexity ให้ข้อมูลผิดพลาด 37% ของคำถามที่ทดสอบ ในขณะที่ ChatGPT ผิดพลาด 67% ส่วน Grok 3 มีอัตราความผิดพลาดสูงสุดที่ 94%

ในการทดสอบ นักวิจัยป้อนข้อความตรงจากบทความข่าวจริงให้กับโมเดล AI จากนั้นขอให้โมเดลระบุหัวข้อข่าว ผู้เผยแพร่ต้นฉบับ วันที่เผยแพร่ และ URL โดยทำการทดสอบทั้งหมด 1,600 คำถามในเครื่องมือค้นหา 8 รายการ

การศึกษาชี้ให้เห็นแนวโน้มทั่วไปของโมเดล AI เหล่านี้ คือ แทนที่จะปฏิเสธการตอบเมื่อไม่มีข้อมูลที่เชื่อถือได้ โมเดลมักจะให้คำตอบที่ดูน่าเชื่อถือแต่ผิดหรือเป็นการคาดเดา นักวิจัยเน้นย้ำว่าพฤติกรรมนี้พบได้ในทุกโมเดลที่ทดสอบ

ที่น่าสนใจคือ เวอร์ชันพรีเมียมที่ต้องจ่ายเงินของเครื่องมือค้นหา AI เหล่านี้กลับทำได้แย่กว่าในบางด้าน โดย Perplexity Pro และ Grok 3 มักให้คำตอบที่ผิดพลาดบ่อยกว่าเวอร์ชันฟรี แม้ว่าโมเดลพรีเมียมจะตอบคำถามได้ถูกต้องมากกว่า

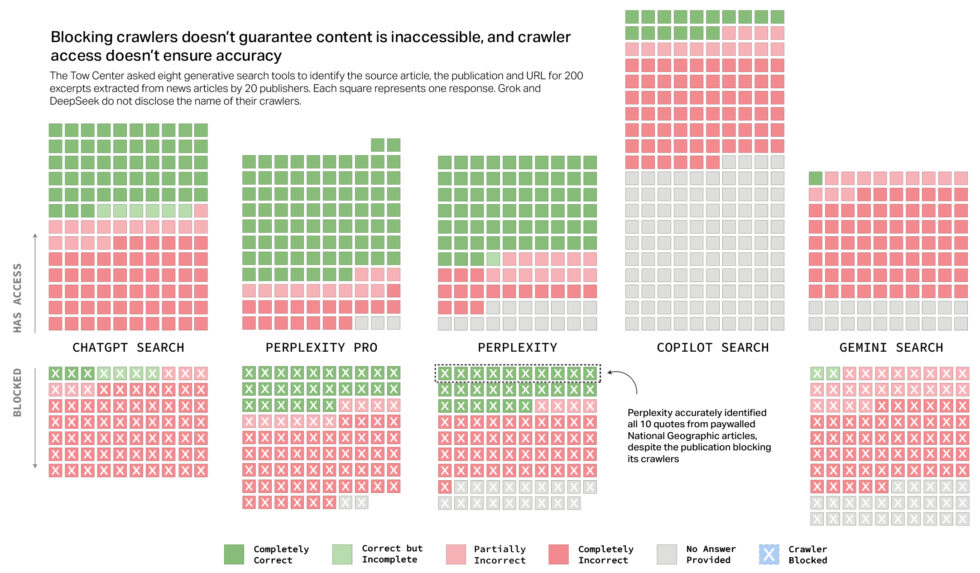

นักวิจัยของ CJR ยังพบหลักฐานที่บ่งชี้ว่าเครื่องมือ AI บางรายการไม่สนใจการตั้งค่า Robot Exclusion Protocol ซึ่งผู้เผยแพร่ใช้เพื่อป้องกันการเข้าถึงโดยไม่ได้รับอนุญาต ตัวอย่างเช่น Perplexity สามารถระบุข้อความทั้งหมด 10 ข้อความจากเนื้อหาที่มี paywall ของ National Geographic ได้อย่างถูกต้อง แม้ว่า National Geographic จะไม่อนุญาต

แม้เครื่องมือค้นหา AI เหล่านี้จะอ้างอิงแหล่งที่มา แต่ก็มักจะนำผู้ใช้ไปยังเนื้อหาที่เผยแพร่บนแพลตฟอร์มอย่าง Yahoo News แทนที่จะเป็นเว็บไซต์ต้นฉบับของผู้นำเสนอ ซึ่งเกิดขึ้นแม้ในกรณีที่ผู้เผยแพร่มีข้อตกลงลิขสิทธิ์กับบริษัท AI

ปัญหาอีกประการคือการสร้าง URL ปลอม โดยมากกว่าครึ่งของการอ้างอิงจาก Gemini และ Grok 3 นำผู้ใช้ไปยัง URL ที่ถูกสร้างขึ้นหรือเปิดจริงไม่ได้ โดยจากการทดสอบการอ้างอิง 200 รายการจาก Grok 3 พบว่า 154 รายการนำไปสู่ลิงก์ที่เปิดจริงไม่ได้