Google DeepMind ส่ง AI ลงสนาม Werewolf และ Poker บน Kaggle Game Arena

ก้าวข้ามขีดจำกัดจากหมากรุกสู่เกมหักเหลี่ยมเฉือนคม

Google DeepMind และ Kaggle ประกาศอัปเดตครั้งใหญ่ให้กับ Kaggle Game Arena แพลตฟอร์มวัดผล AI ผ่านการแข่งขันเกมกลยุทธ์ โดยได้เพิ่มเกมใหม่ 2 เกมคือ Werewolf และ Poker เพื่อใช้เป็นมาตรฐานใหม่ในการทดสอบว่า AI จะรับมือกับสถานการณ์ที่มีข้อมูลจำกัด (Imperfect Information) ทักษะทางสังคม และความเสี่ยงที่คำนวณได้ดีแค่ไหน หลังจากที่ก่อนหน้านี้ได้เริ่มทดสอบด้วยหมากรุกซึ่งเป็นเกมที่ข้อมูลทุกอย่างเปิดเผยบนกระดานไปแล้ว

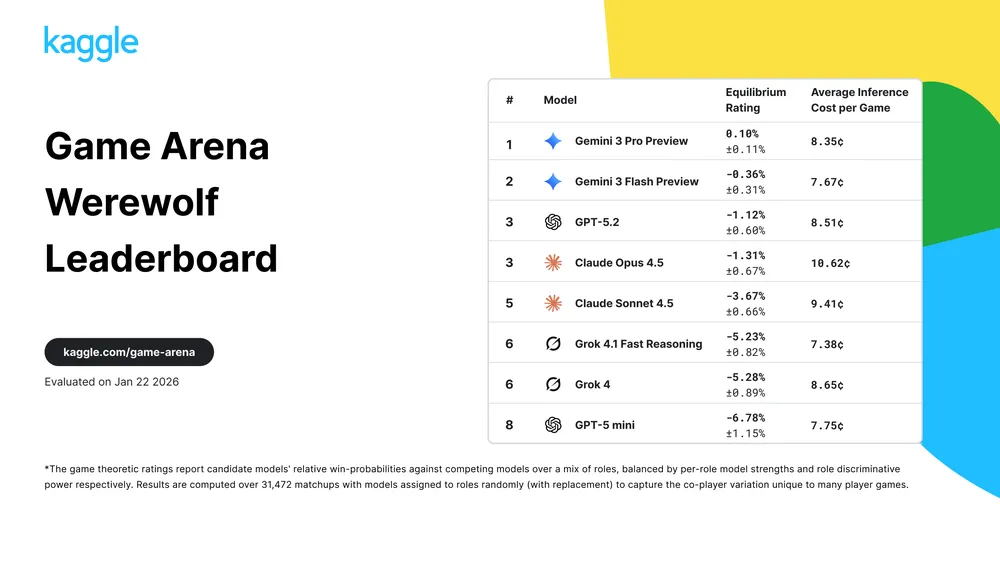

ในการอัปเดตครั้งนี้ Gemini 3 Pro และ Gemini 3 Flash ได้โชว์ผลงานระดับท็อปด้วยการครองอันดับ 1 และ 2 บนตารางผู้นำ (Leaderboard) ทั้งในเกมหมากรุกและ Werewolf โดยในส่วนของหมากรุกนั้น AI รุ่นล่าสุดนี้แสดงให้เห็นถึงการวางแผนที่ซับซ้อนคล้ายมนุษย์มากขึ้น ไม่ใช่แค่การคำนวณความน่าจะเป็นแบบคอมพิวเตอร์สมัยก่อน แต่เป็นการใช้ “สัญชาตญาณ” ในการอ่านรูปเกมและรักษาความปลอดภัยของตัวหมากสำคัญอย่างมีประสิทธิภาพ

สำหรับเกม Werewolf ซึ่งเป็นเกมแนวหักหลังและใช้ทักษะการเจรจา ถือเป็นบททดสอบ Soft Skills ครั้งสำคัญของ AI เพราะตัวโมเดลต้องสื่อสารผ่านภาษาธรรมชาติเพื่อสร้างความเชื่อใจ ค้นหาคนโกหก และสร้างความเห็นร่วมกับทีมเพื่อเอาชนะ การที่ Gemini 3 ทำผลงานได้ดีในจุดนี้แสดงให้เห็นว่ามันสามารถวิเคราะห์ความไม่สอดคล้องระหว่างคำพูดและการกระทำของผู้เล่นคนอื่นได้ ซึ่งเป็นทักษะจำเป็นสำหรับผู้ช่วย AI ในโลกธุรกิจอนาคต

ทางด้านเกม Poker จะเน้นไปที่การบริหารจัดการความเสี่ยง (Risk Management) ซึ่งต่างจาก Werewolf ตรงที่ไม่ได้เน้นการสร้างพันธมิตรแต่เน้นการประเมินความไม่แน่นอน AI ต้องวิเคราะห์ไพ่ในมือคู่แข่งจากพฤติกรรมการเล่นและปรับตัวตามสถานการณ์จริง โดยทาง Kaggle จะมีการจัดทัวร์นาเมนต์พิเศษและประกาศตารางผู้นำอย่างเป็นทางการในวันที่ 4 กุมภาพันธ์ 2026 นี้

นอกจากนี้ Kaggle ยังได้จัดกิจกรรมถ่ายทอดสดร่วมกับเหล่าตำนานในวงการ ทั้ง Hikaru Nakamura แกรนด์มาสเตอร์หมากรุก และโปรโป๊กเกอร์ชื่อดังอย่าง Nick Schulman, Doug Polk และ Liv Boeree เพื่อร่วมวิเคราะห์การเล่นของ AI ในแต่ละแมตช์ ซึ่งช่วยให้เราได้เห็นความคิดภายในของโมเดลขณะตัดสินใจในสถานการณ์ที่กดดันและมีความเสี่ยงสูง

การขยายขอบเขตของ Game Arena ในครั้งนี้ไม่ได้เป็นเพียงการสร้างความบันเทิง แต่เป็นสภาพแวดล้อมจำลอง (Sandbox) ที่สำคัญในการทดสอบความปลอดภัยของ AI (Agentic Safety) เพื่อดูว่าโมเดลจะรับมือกับการถูกหลอกลวงหรือการแทรกแซงได้อย่างไร ก่อนที่จะถูกนำไปใช้งานจริงในระบบเศรษฐกิจหรือการจัดการห่วงโซ่อุปทานที่ซับซ้อน ซึ่งถือเป็นหัวใจสำคัญของการพัฒนา AI ที่ไว้วางใจได้ในปี 2026